【TechWeb】5月20日消息,根据中国信通院发布的大模型推理能力评估结果,百度文心X1 Turbo在24项能力评估中,16项达5分、7项达4分、1项达3分,综合评级获当前最高级“4+级”,成为国内首款通过该测评的大模型。文心X1 Turbo逻辑推理、代码推理、推理效果优化等技术能力及工具支持度、安全可靠度等应用能力均获得满分。

百度文心X1 Turbo大模型取得如此优秀表现背后,有哪些技术创新呢?

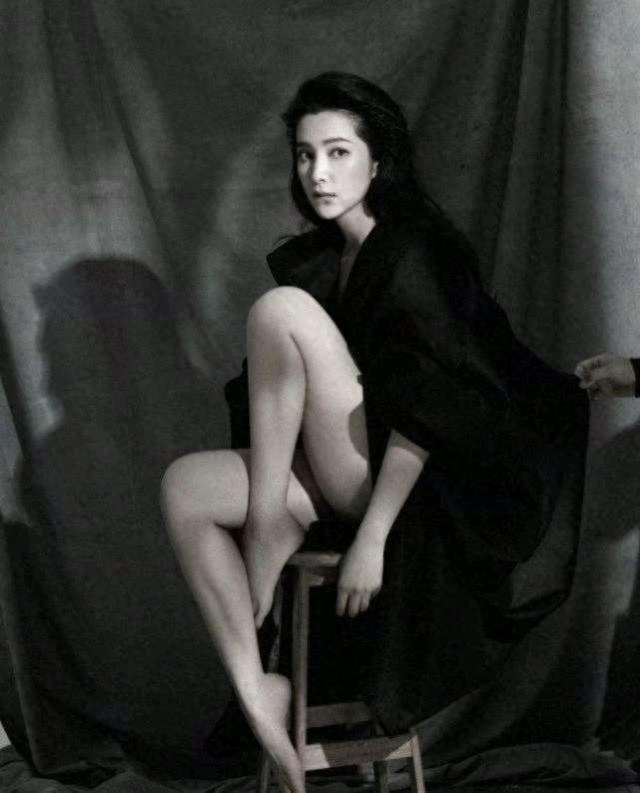

百度集团副总裁吴甜在百度AI Day上进行了分享。

百度集团副总裁吴甜

吴甜对文心大模型最新版本的技术创新进行了系统性的讲解。她介绍,文心大模型4.5是多模态基础大模型,文心4.5 Turbo源自文心4.5,效果更好、成本更低;基于文心4.5 Turbo,文心X1升级到X1 Turbo,性能提升的同时,具备更先进的思维链,问答、创作、逻辑推理、工具调用和多模态能力进一步增强。

文心4.5和4.5 Turbo实现了文本、图像和视频的混合训练。针对不同模态数据在结构、规模、知识密度上的差异,通过多模态异构专家建模、自适应分辨率视觉编码、时空重排列的三维旋转位置编码、自适应模态感知损失计算等技术,大幅提升跨模态学习效率和多模态融合效果,学习效率提高近2倍,多模态理解效果提升超过30%。

后训练方面,百度研制了自反馈增强的技术框架,基于大模型自身的生成和评估反馈能力,实现了“训练-生成-反馈-增强”的模型迭代闭环,让大模型拥有了自我迭代的“最强大脑”,不仅解决了大模型对齐过程中,数据生产难度大、成本高、速度慢等问题,而且显著降低了模型幻觉,模型理解和处理复杂任务的能力大幅提升。

在训练阶段,通过融合偏好学习的强化学习技术,实现多元统一奖励机制,提升了对结果质量判别的准确率。通过离线偏好学习和在线强化学习统一优化,进一步提升了数据利用效率和训练稳定性,并增强了模型对高质量结果的感知。此外,通过偏好信号与奖励信号的融合运用,模型的理解、生成、逻辑和记忆等能力全面提升。

深度思考方面,突破了仅基于思维链优化的范式,在思考路径中结合工具调用,构建了融合思考和行动的复合思维链,模型解决问题能力得到显著提升,模型输出结果思路清晰、逻辑严密,表达自然。同时,结合多元统一的奖励机制,实现了思考和行动链的端到端优化,大幅提升了跨领域的问题解决能力。

数据方面,打造了“数据挖掘与合成 - 数据分析与评估 - 模型能力反馈”的数据建设闭环,为模型训练源源不断地生产知识密度高、类型多样、领域覆盖广的大规模数据。同时,数据建设流程具备良好的可扩展性,能够轻松迁移到全新的数据类型,实现快速、高效的数据生产。

此外,吴甜也指出,大模型的能力进一步拓展、效率进一步提升之后,可以探索更前瞻、更有想象力的创新应用。

以数字人为例,超拟真数字人需要具备出色的表现力、吸引人的内容、数字人与场景、物品的互动等,需要综合运用多模态AI技术。百度研制了“剧本”驱动多模协同的超拟真数字人技术,实现了语言、声音、形象的协调一致。目前这套技术已经支持超过10万数字人主播,直播转化率达31%,降低80%直播开播成本。在代码场景上,基于文心大模型的语言和代码能力,百度研制了代码智能体和智能代码助手——文心快码。百度每天新增的代码中,文心快码生成的代码占比已超过40%。截至目前,文心快码向全社会开放,累计服务760万开发者。

此外,吴甜强调,文心大模型的能力拓展和效率提升,得益于飞桨文心的联合优化,包括框架模型的联合优化,也包括框架算力的联合优化。通过训练和推理的技术创新,文心4.5 Turbo训练吞吐达到文心4.5的5.4倍,推理吞吐达到8倍。

目前,飞桨文心开发者数量已超过2185万,服务超过67万家企业,创建的模型达到110万。基于飞桨深度学习平台和文心大模型,百度在上海、广州、南京、武汉、厦门、宁波、南昌、无锡等多地落地产业赋能中心、数据生态中心和教育创新中心,以科技+人才+创新的模式打造区域人工智能公共技术服务平台,汇聚行业高价值数据集、培养新型复合型人才、赋能本地AI产品研发,构建围绕人工智能核心能力的“政产学研用”协同发展机制,加快区域产业智能化升级。

0 条